Lokale Ausführung einer AI-Anwendung

Nutzen von lokal gehosteten Daten und einer AI-Engine

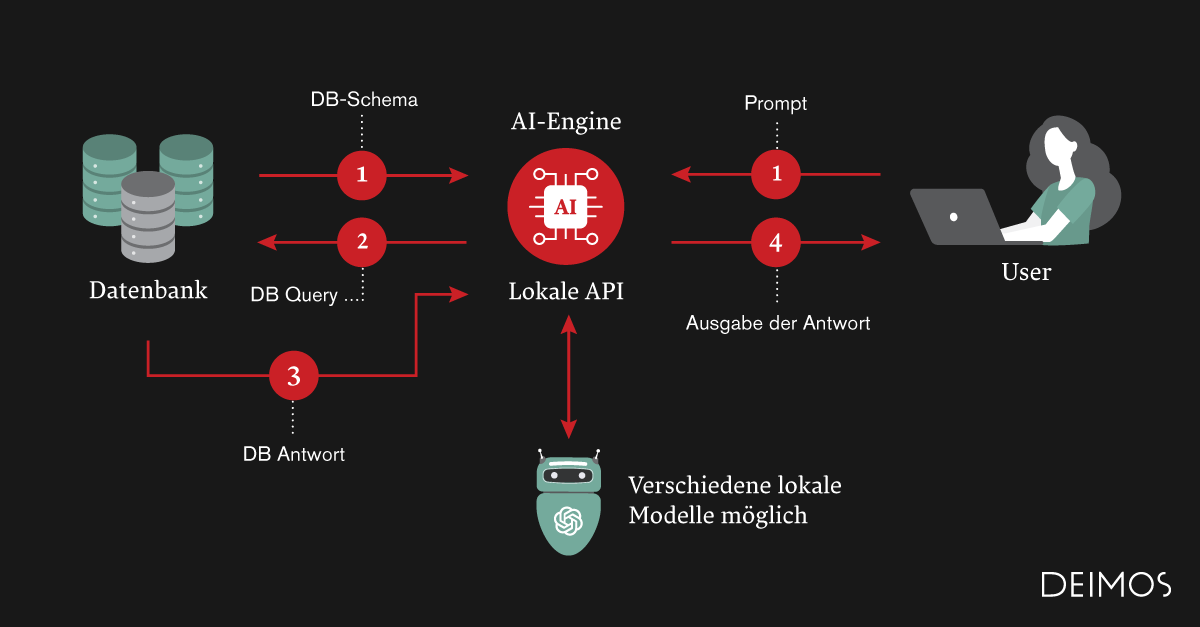

Die dargestellte Grafik illustriert, wie mittels einer Artificial Intelligence und einer Datenbank eine Anfrage eines Benutzers beantwortet werden kann.

Sie beinhaltet folgende Komponenten:

- Datenbank: In der Datenbank sind sämtliche für die Beantwortung der Frage relevanten Informationen gespeichert. Das Datenbank-Schema definiert die Struktur der gespeicherten Daten.

- AI-Engine: Die AI-Engine kann entweder lokal auf einem betriebsinternen Server oder in der Cloud laufen. Bei einer lokalen Engine werden keine Daten ins Internet geschickt, somit ist der Datenschutz bei dieser Lösung in jedem Fall gewährleistet. Es sind auch gemischte Lösungen möglich, bei denen nicht heikle Daten in der Cloud verarbeitet werden und heikle Daten lokal.

- Benutzer: Der Benutzer interagiert mit der AI über ein grafisches User-Interface, indem er seine Fragen eingeben kann. Die AI-Engine verarbeitet diese Anfragen und gibt ihm eine passende Antwort aus.

Die Beantwortung einer Anfrage ist in 4 Schritte gegliedert:

- Der Benutzer gibt seine Anfrage ein, entweder via Text oder Spracheingabe. Diese Anfrage wird zusammen mit dem Datenbank-Schema an die AI geschickt.

- Die AI generiert aus der Anfrage und dem Datenbank-Schema ein Datenbank-Abfrage.

- Diese Datenbank-Abfrage wird auf der Datenbank ausgeführt und die Antwort wird an die AI geschickt.

- Die AI generiert basierend auf der originalen Anfrage und der Datenbank-Antwort die Antwort für den Benutzer. Die Antwort kann entweder in Text oder Sprachform ausgegeben werden.

Diese Architektur lässt sich auf beliebige strukturierte wie unstrukturierte Daten erweitern, z.B. folgende:

- PDF-Dokumente

- Word-Dokumente

- Webseiten-Inhalte

- REST-Schnittstellen

- E-Mails

Es können mehrere verschiedene Datenquellen kombiniert werden, die AI-Engine wählt dann jeweils die für die Beantwortung der Frage passenden Datenquellen aus.

Hinter jeder AI-Engine steht ein Large Language Model (LLM), welches für die Generierung der Antworten zuständig sind. Dieses LLM kann ein beliebiges lokales Modell oder Cloud-Modell sein, z.B. Llama (lokales Modell) oder GPT-4 (OpenAI-Modell). Die lokalen Modelle nähern sich von der Qualität her immer mehr den Cloud-Modellen an, so dass in beiden Varianten vergleichbare Ergebnisse zu erwarten sind und die Entscheidung rein aufgrund der Anforderungen des Projekts getroffen werden kann.

Datenschutz hat Vorrang

Die Integration von AI in lokale Datenbanksysteme zeigt eindrucksvoll, wie technologischer Fortschritt die Informationsverarbeitung revolutionieren kann.

Durch die Nutzung von lokalen Large Language Models kombinieren wir das Beste aus Datenschutz und effizienter Datenverarbeitung, um den stetig wachsenden Informationsbedarf zu decken.

Diese Entwicklung ebnet den Weg für eine Zukunft, in der intelligente Systeme nahtlos und sicher in unseren Alltag integriert sind.